始めに

今IT業界では、生成AIによってかつてないほどの大きな変動が起きています。

「AIがコードを書く時代」において、私たちWEBエンジニアには何が求められるのでしょうか?

単にAIにコードを書かせるだけではなく、AIをツールとして使いこなし、

開発速度や精度を劇的に向上させるための「新しいスキルセット」が必要とされています。

この記事では、スタンフォード大学が無料公開している講義資料について紹介します。

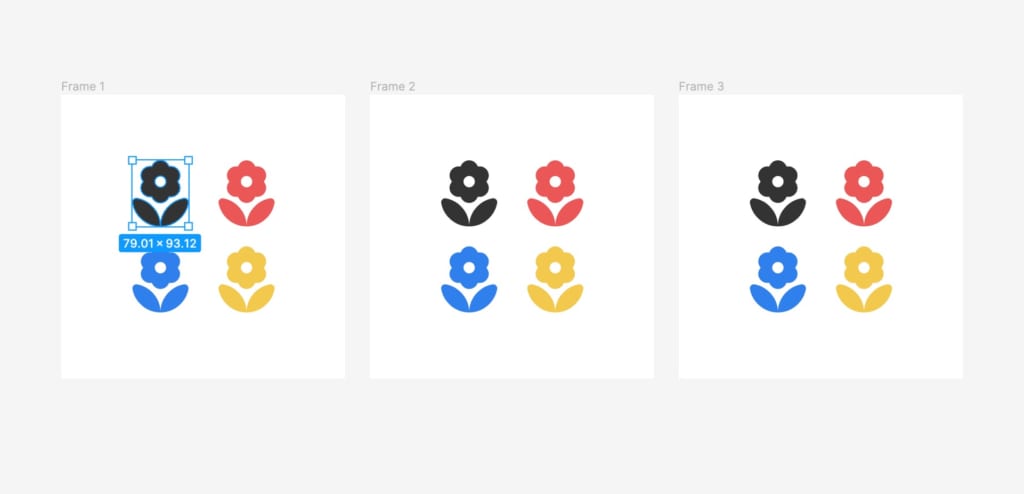

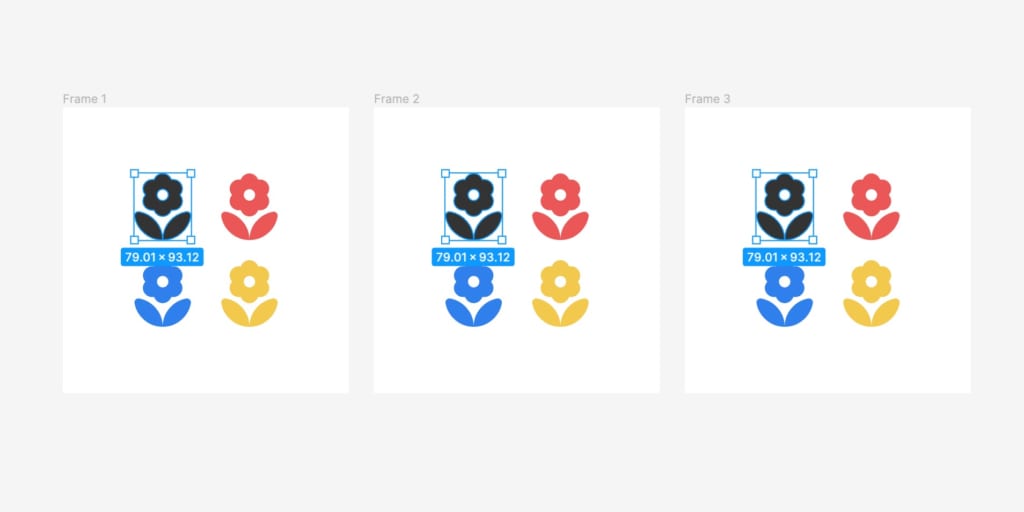

公式サイト(https://themodernsoftware.dev)

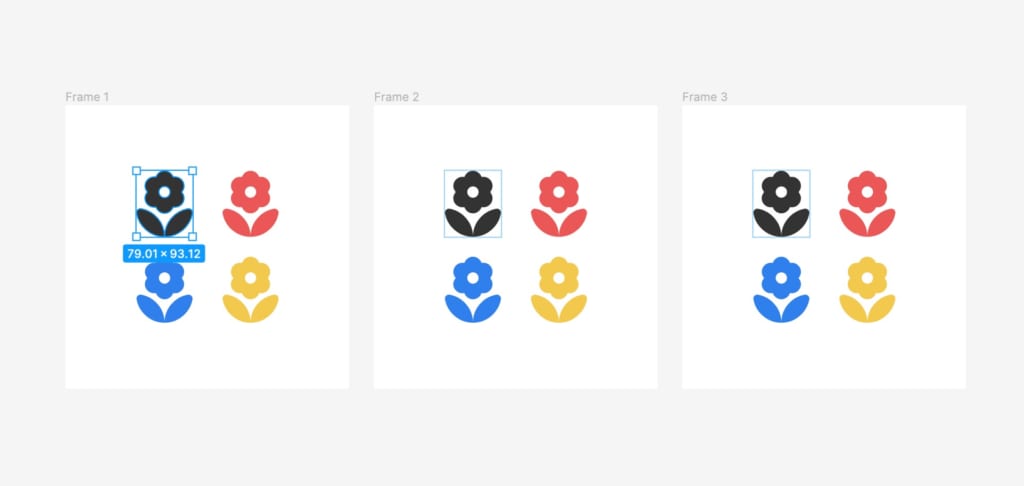

サイト内の「Syllabus」タブをクリックすると、各週の講義スライドやおすすめの関連記事を閲覧できます。

無料公開されているのはスライドと記事のみですが、非常に参考になる内容のため、今回紹介いたしました。

CS146S: The Modern Software Developer とは?

このコースは、スタンフォード大学で2025年秋学期に開講される「現代のソフトウェア開発者」のための授業です。

従来のプログラミング教育が「ゼロからコードを書く力」に重点を置いていたのに対し、

このコースではAIツールを前提とした開発ワークフローへと完全にシフトしています。

「これからの時代に必須となるスキルを身につけたい」というエンジニアの方は必見の内容です。

各週のテーマを日本語でまとめてみました:

Week 1: Introduction to Coding LLMs and AI Development

(コーディングLLMとAI開発への導入)

Week 2: The Anatomy of Coding Agents

(コーディング・エージェントの解剖学)

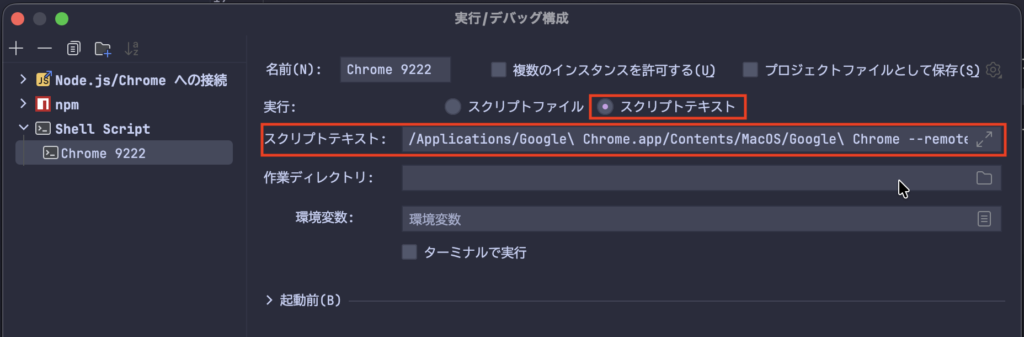

Week 3: The AI IDE

(AIネイティブなIDE)

Week 4: Coding Agent Patterns

(コーディング・エージェントのパターン)

Week 5: The Modern Terminal

(モダンなターミナル環境)

Week 6: AI Testing and Security

(AIによるテストとセキュリティ)

Week 7: Modern Software Support

(モダンなソフトウェア・サポート / レビュー・ドキュメント)

Week 8: Automated UI and App Building

(UIとアプリ構築の自動化)

Week 9: Agents Post-Deployment

(デプロイ後のエージェント活用 / 運用監視)

Week 10: What's Next for AI Software Engineering

(AIソフトウェアエンジニアリングの未来)

最後

今回の紹介は以上です。

サイトは英語のみですが、講義資料はスライド形式なので、翻訳ツールなどを使いながら読むだけでも非常に勉強になると思います。

また時間が取れたときに、それぞれの講義内容をまとめ記事も書くかもしれません。

参照リンク

公式サイト: themodernsoftware.dev

コースの課題:https://github.com/mihail911/modern-software-dev-assignments/tree/master